Чему я научился, обучая людей этике ИИ

На одном из недавних тренингов кто-то поднял руку и спросил: «Может ли ИИ быть этичным, если люди такими не являются?»

Я задумался. Не потому что вопрос был плох, а потому что он был правильным, и я не был уверен, готова ли аудитория услышать мой ответ.

Проблема не в машине

Большинство сбоев ИИ — это не технические сбои. Это человеческие ошибки, замаскированные под технические проблемы.

Плохие инструкции, игнорирование контекста, слепое доверие, непроверенные предположения - всё это может привести к сбою. Я видел команды, которые внедряли ИИ‑инструменты, не до конца их понимая, автоматизировали решения, которые не могли объяснить, и удивлялись, когда что-то шло не так.

ИИ не провалился. Люди не задали правильные вопросы до того, как нажали «запустить».

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Как я стал преподавателем этики

Я не планировал преподавать этику ИИ. Моя задача была проста: помочь организациям внедрить Salesforce AI, не нарушая процессы.

Но каждая техническая беседа возвращалась к неудобным вопросам:

• Кто несёт ответственность, если система ошибётся?

• Что произойдёт, если кто-то пострадает из-за автоматического решения?

• Как мы узнаем, что система не усугубляет ситуацию вместо того, чтобы улучшить её?

Это уже не технические вопросы. Это этические вопросы.

Большинство людей, работающих с ИИ, не обучены думать в таких терминах.

Истории важнее чеклистов

Я понял: этику нельзя преподавать через чеклист.

Люди не чувствуют фразы вроде «обеспечьте прозрачность алгоритма» или «сведите к минимуму предвзятость в данных». Они звучат важно, но ничего не значат, пока не сделать их реальными.

Поэтому я стал рассказывать истории.

Одна из них:

Некоммерческая организация использовала ИИ, чтобы определить, каким донорам звонить во время ежегодной кампании. Система работала идеально: количество звонков выросло, эффективность увеличила��ь, сотрудники были довольны.

Но кто-то заметил, что давние доноры, которые давали небольшие суммы, больше не получали звонков. ИИ понял, что «большие подарки = высокий приоритет», что логично с точки зрения дохода.

Но маленькие доноры? Многие из них поддерживали организацию 20+ лет. Они не были высокодоходными, но оставались лояльными. Когда они перестали получать внимание, некоторые прекратили пожертвования.

ИИ ничего не нарушил. Он просто оптимизировал то, чему его научили.

Люди забыли спросить:

Что мы жертвуем ради этой эффективности?

Принцип заголовка

Теперь, когда я объясняю этику ИИ, я использую простой принцип: Если решение вашей системы завтра окажется в заголовках новостей, будете ли вы этим гордиться?

Не «соответствует ли это юридическим нормам». Не «можно ли защитить это с точки зрения политики компании».

Будете ли вы гордиться? Можете ли вы спокойно объяснить это команде, совету или обществу?

Если ответ «нет» или «не уверен», значит у вас этическая проблема, а не техническая.

Управление как эмпатия

Многие думают, что управление - это бюрократия: правила, документация, процессы одобрения, которые замедляют работу.

Но хорошее управление - это эмпатия в масштабе.

Это значит задавать вопросы: кто может пострадать? Что может пойти не так? Как мы это заметим? Что мы сделаем, чтобы исправить?

Эмпатия не замедляет процесс, она помогает избежать ошибок, о которых вы потом пожалеете.

Пример: клиент хотел использовать ИИ для рекомендаций по стипендиям. Отличная идея, но ист��рические данные отражали старые предвзятости.

Если бы ИИ был запущен без проверки, система автоматизировала бы старые ошибки. Эмпатия помогла вовремя остановить запуск и переработать набор данных.

Чему мы должны научиться

ИИ сам по себе не хорош и не плох. Он отражает приоритеты и слепые зоны людей, которые его создают, и данные, на которых он обучается.

Для этичного ИИ нужны этичные люди, которые задают трудные вопросы:

• Что мы оптимизируем, а что игнорируем?

• Кто выигрывает, а кто может пострадать?

• Можем ли мы это объяснить другим понятно?

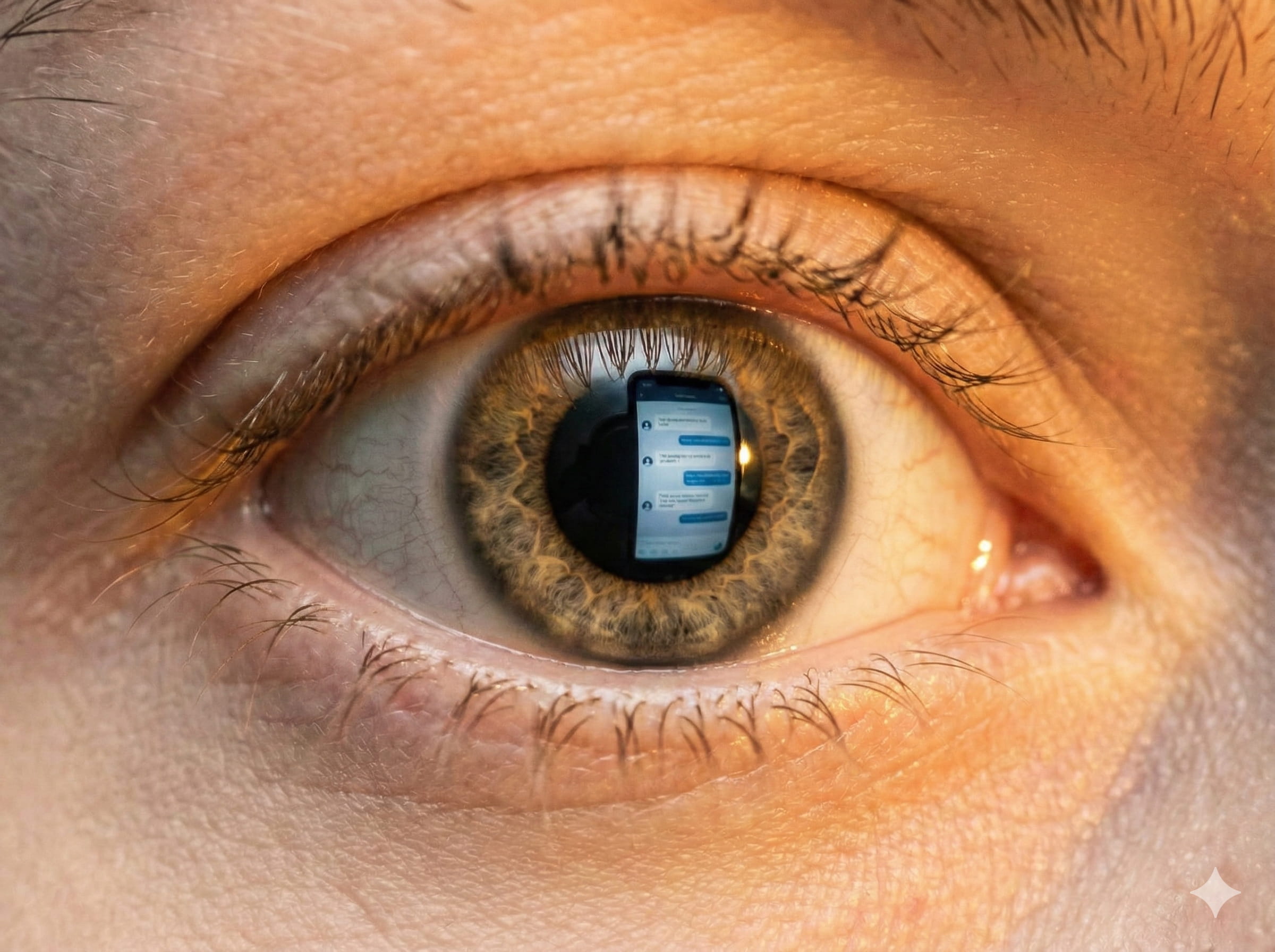

Этика - это не чеклист. Это линза, через которую смотрят на каждое решение.

Возвращаясь к вопросу

Может ли ИИ быть этичным, если люди такими не являются?

Нет.

Но есть более важный вопрос: может ли работа с ИИ сделать людей более этичными?

Я думаю, что да, если использовать это как возможность проверить свои предположения, уточнить ценности и построить системы, отражающие мир, который мы действительно хотим создать.

Нам не нужны умнее машины. Нам нужны яснее люди.

Этика ИИ - это сложная тема, и у каждого своё видение. Как вы думаете, что важнее: дать машинам делать быстро или иногда нажимать на паузу и подумать?

Будет интересно прочитать ваши мысли в комментариях! Спасибо за прочтение!

-

Кому принадлежит Gemini?

-

Как работает Gemini?

-

Является ли Gemini точным?

-

Может ли Gemini помочь с конкретными задачами или вопросами?

-

Является ли Gemini бесплатным сервисом?

-

Можно ли использовать Gemini на мобильных устройствах?

-

Доступен ли Gemini на разных языках?

-

Как начать работу с Gemini?

Войти в Gemini: быстрый и безопасный доступ к вашему ИИ-помощнику

- Исследуйте возможности Gemini, передового ИИ от Google, созданного для преобразования вашей работы и творчества.

Что такое Gemini

- Gemini — это революционная разработка в области искусственного интеллекта, созданная компанией Google. Этот многофункциональный ИИ-помощник

Регистрация Gemini в России: Полное Руководство

- Gemini — это многофункциональный искусственный интеллект, способный генерировать тексты, переводить языки, писать код, анализировать данные и многое