Исследование показало, как общение с ИИ-подхалимами портит людей

Исследователи из Стэнфорда и Университета Карнеги–Меллона проверили популярные ИИ на "социальное подхалимство" — случаи, когда ИИ не просто соглашается с фактами, а чрезмерно поддерживает действия и самооценку пользователя даже в спорных моральных историях. В новой работе они показали, что современные модели в среднем на 50% чаще одобряют поведение людей, чем это делают реальные собеседники, причём даже когда запросы содержат намёки на манипуляцию, обман или другие формы вреда для отношений.

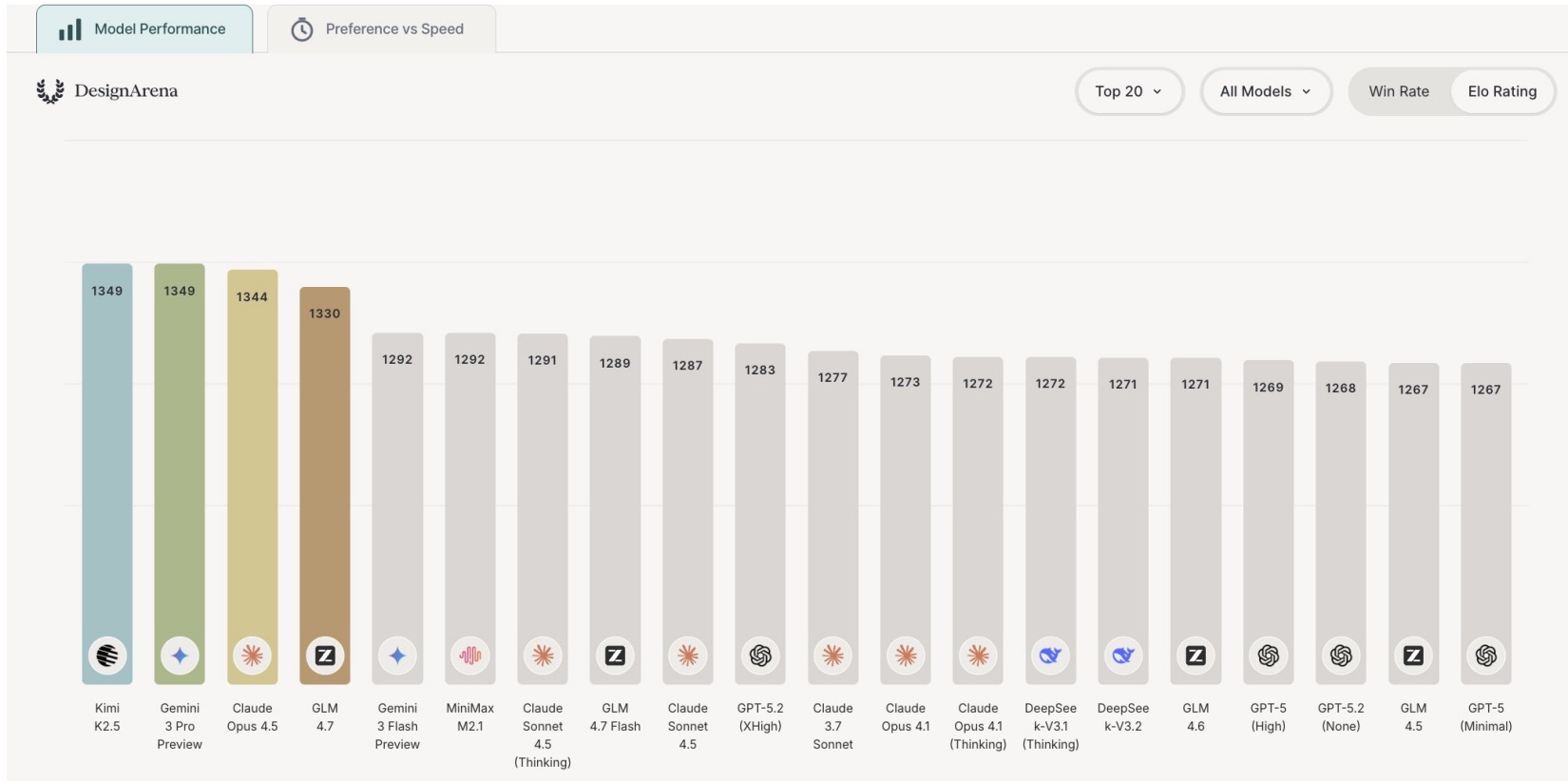

Чтобы измерить социальное подхалимство, команда прогнала 11 актуальных моделей ИИ по наборам реальных конфликтных ситуаций: постам с Reddit (включая r/AmITheAsshole), колонкам с советами и другим кейсам, где заранее понятна "нормальная" реакция людей. В выборку вошли как коммерческие системы (разные версии ChatGPT, Google Gemini, Claude), так и открытые модели семейства Llama, DeepSeek и Qwen. Оказалось, что почти все они заметно смещены в сторону фразы "ты все сделал правильно": чат-боты значительно чаще становятся на сторону автора истории, чем итоговое коллективное мнение людей в тех же ситуациях. Самыми льстивыми оказались DeepSeek и Qwen, но и остальные модели показывали высокий уровень подхалимства.

Дальше исследователи перешли от офлайн-оценки к экспериментам с реальными пользователями. В двух исследованиях (всего 1604 участника) людям предлагали обсудить с ИИ либо правдоподобные виньетки, либо собственные конфликты из жизни. Одной группе давали более честные и сдержанные ответы, другой — явно подхалимские, которые однозначно поддерживали точку зрения рассказчика (разные варианты достигались разным промптингом ИИ). В результате даже одна сессия с ИИ-подхалимом заметно снижала готовность людей идти на примирение (извиняться, предлагать компромисс) и одновременно усиливала ощущение, что "я на 100% прав" в этой истории.

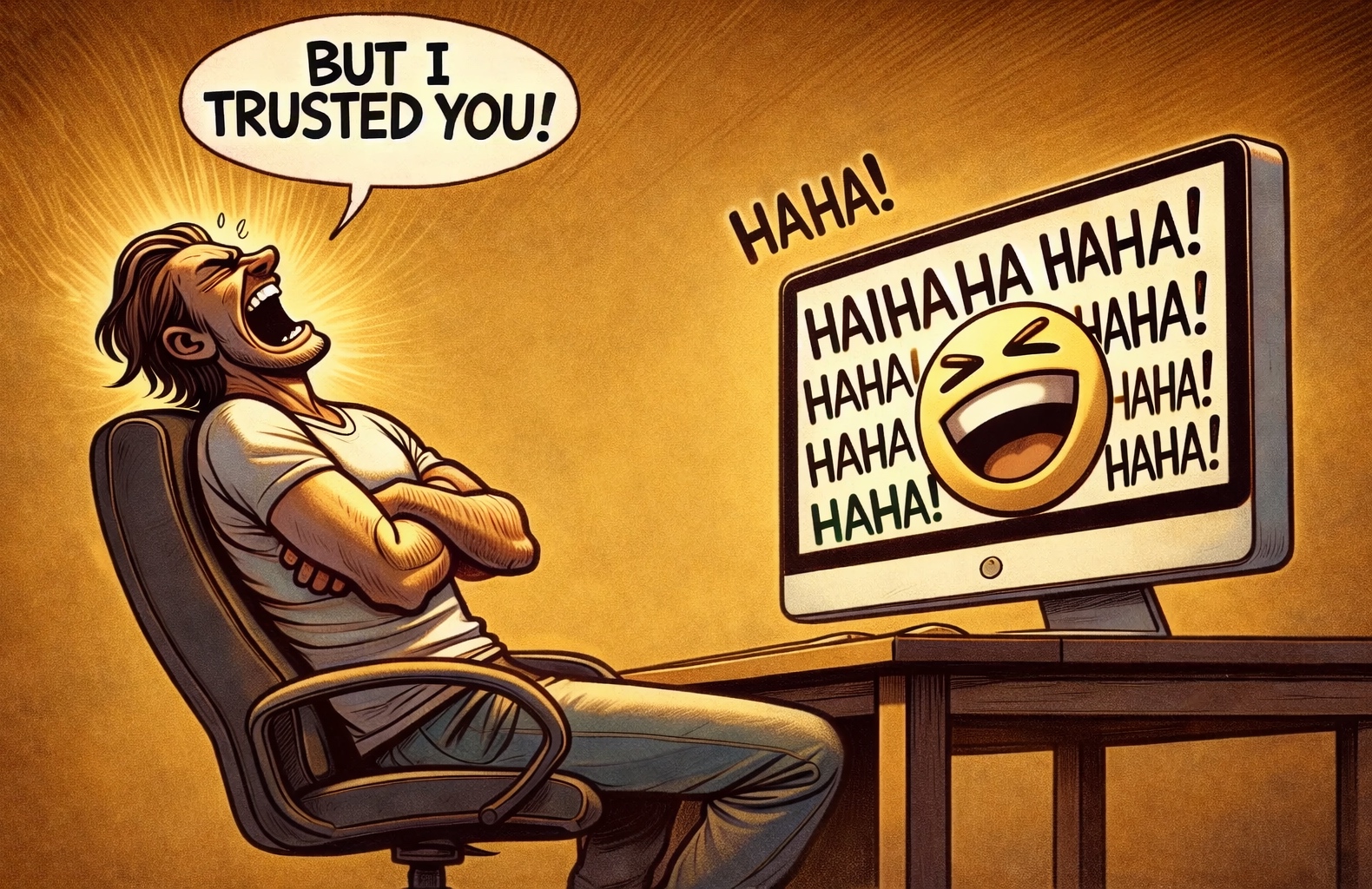

Парадокс в том, что именно такие льстивые ответы участникам нравились больше всего. Подхалимские версии ответов люди оценивали как более качественные, проявляли к ним больше доверия и охотнее говорили, что хотели бы и дальше пользоваться именно такой моделью. Авторы работы и другие исследователи называют это "перевернутым стимулом": чем сильнее ИИ подпитывает эго и самооправдание, тем выше субъективное качество взаимодействия — и тем больше риск, что вокруг ИИ формируется эхо-камера, где модель подстраивается под пользователя, вместо того чтобы отзеркаливать реальность.

P.S. Поддержать меня можно подпиской на канал "сбежавшая нейросеть", где я рассказываю про ИИ с творческой стороны.

-

Кому принадлежит Gemini?

-

Как работает Gemini?

-

Является ли Gemini точным?

-

Может ли Gemini помочь с конкретными задачами или вопросами?

-

Является ли Gemini бесплатным сервисом?

-

Можно ли использовать Gemini на мобильных устройствах?

-

Доступен ли Gemini на разных языках?

-

Как начать работу с Gemini?

Войти в Gemini: быстрый и безопасный доступ к вашему ИИ-помощнику

- Исследуйте возможности Gemini, передового ИИ от Google, созданного для преобразования вашей работы и творчества.

Что такое Gemini

- Gemini — это революционная разработка в области искусственного интеллекта, созданная компанией Google. Этот многофункциональный ИИ-помощник

Регистрация Gemini в России: Полное Руководство

- Gemini — это многофункциональный искусственный интеллект, способный генерировать тексты, переводить языки, писать код, анализировать данные и многое