«Закон уплотнения» LLM: плотность способностей удваивается каждые 3,5 месяца

TL;DR

-

Предлагается «закон уплотнения» для больших языковых моделей: максимальная плотность способностей удваивается примерно каждые 3,5 месяца. То есть всё больше качества удаётся выжать из каждого параметра модели.

-

Вводится метрика плотности способностей: считается, сколько параметров потребовалось бы референсной модели, чтобы показать такое же качество, и это число сравнивается с реальным количеством параметров. Так видно, какие модели обучены «экономно», а какие — расточительно.

-

Анализ по нескольким бенчмаркам (MMLU, BBH, MATH, HumanEval, MBPP и MMLU-CF без утечек в тренировочные данные) показывает устойчивый экспоненциальный рост плотности, а не артефакт контаминации тестов.

-

При фиксированном целевом качестве необходимое число параметров падает экспоненциально, а вместе с оптимизацией инференса это ведёт к резкому удешевлению токенов: от десятков долларов за миллион токенов до сотых долей доллара за пару лет.

-

В связке с законом Мура это даёт агрессивный сценарий: всё более мощные модели смогут работать локально на потребительском железе, без обязательного обращения к облаку.

-

Классический «просто нарастим параметры и датасет» теряет смысл: у каждой модели есть короткое окно выгодности, после чего выходят более плотные аналоги. Это смещает фокус к density-optimal обучению — архитектуры, пайплайны данных, distillation и другие методы, которые повышают качество на один параметр, а не только общий масштаб.

Предложен своего рода «новый закон Мура» — но не для транзисторов, а для больших языковых моделей. В работе в Nature Machine Intelligence вводится метрика «плотность способностей» (capability density) и показывается, что максимальное значение этой метрики для открытых LLM растёт экспоненциально и примерно удваивается каждые 3,5 месяца.

От скейлинга к эффективности

Классические scaling laws описывают зависимость качества модели от числа параметров и обучающих токенов. Логика простая: больше параметров и данных — лучше результат, что и привело к гонке за сотнями миллиардов параметров. На практике же всё чаще упирается не в обучение, а в стоимость и скорость инференса: модели нужно крутить в проде, на ограниченном железе и с понятной экономикой.

Возникает вопрос: как оценивать эффективность моделей, а не только «сырую» производительность? Нужна метрическая шкала, которая учитывает и качество, и размер модели.

Что такое «плотность способностей»

Плотность в интуитивном смысле — это «сколько полезной способности приходится на один параметр». Однако прямое деление score на MMLU на число параметров не работает: зависимость нелинейная. В статье предлагается относительная конструкция.

Сначала выбирается референс-модель, для которой строится кривая масштабирования: качество на задачах в зависимости от числа параметров. Затем:

-

для любой другой модели рассчитываются её «эффективные параметры» — сколько параметров потребовалось бы референсу, чтобы показать такое же качество;

-

плотность способностей определяется как отношение эффективных параметров к фактическим.

Если модель «выжимает» из своих параметров больше, чем ожидалось по кривой скейлинга референса, плотность > 1; если меньше — < 1.

Оценка проводится сразу на пяти популярных бенчмарках: MMLU, BBH, MATH, HumanEval и MBPP, то есть покрываются знания, логическое и математическое рассуждение и кодогенерация.

«Закон уплотнения»: удвоение каждые 3,5 месяца

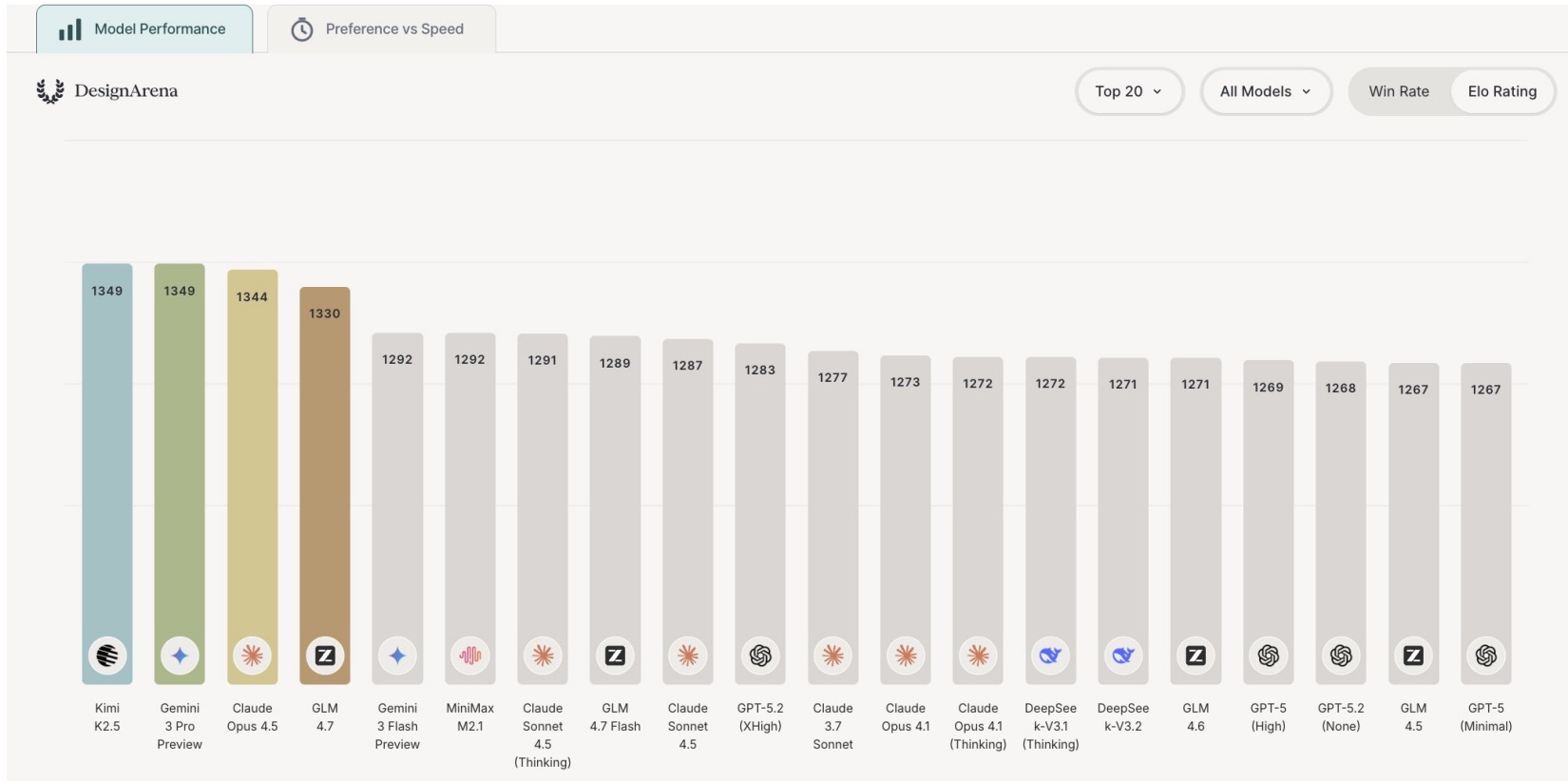

Анализируются 51 открытая базовая LLM (без instruction-tuning), начиная с Llama-1: классические плотные Transformer, MoE-модели, квантизованные варианты.

Если смотреть на верхнюю огибающую — лучшие модели по плотности на каждом шаге времени, — логарифм максимальной плотности хорошо аппроксимируется линейной функцией

где t — количество дней с момента выхода Llama-1.

Оценка коэффициента даёт A ≈ 0,007, откуда следует, что максимальная плотность способностей удваивается примерно каждые:

При этом более крупная модель не обязательно плотнее. Например, очень большие модели вроде Llama-3.1-405B демонстрируют высокое абсолютное качество, но не максимальную плотность: сверхкрупные конфигурации сложнее довести до оптимума по качеству на один параметр.

Проверка на contamination-free датасете

Основные использованные бенчмарки открыты, что всегда оставляет риск утечки обучающих данных в тест. Чтобы отфильтровать этот эффект, дополнительно используется MMLU-CF — вариант MMLU, сформированный в декабре 2024 года с контролем на отсутствие пересечений с известными тренировочными корпусами.

Экспоненциальный рост максимальной плотности сохраняется и здесь. Оценённый коэффициент наклона почти не меняется (разница порядка единиц процентов), качество аппроксимации даже улучшается. Это указывает на то, что «закон уплотнения» не является артефактом контаминации тестов.

Меньше параметров — та же мощность

Из определения плотности следует важный практический вывод: при фиксированном целевом качестве количество параметров «равноценной» модели падает во времени экспоненциально.

В работе приводится пример: MiniCPM-1-2.4B (февраль 2024) достигает уровня Mistral-7B (сентябрь 2023), имея всего порядка 35% её параметров. При прочих равных это означает резкое снижение стоимости инференса — от требований к памяти до числа активных вычислений.

Отдельно анализируются цены API моделей, превосходящих GPT-3.5 по качеству. По этим данным стоимость миллиона токенов инференса падает примерно вдвое каждые 2,6 месяца. Пример: в декабре 2022 GPT-3.5 стоил около 20 долларов за миллион токенов, а к августу 2024 Gemini-1.5-Flash — уже 0,075 доллара (падение более чем в 260 раз).

Этот тренд складывается из двух факторов: роста плотности способностей и непрерывной оптимизации систем инференса (архитектура внимания, sparsity, работа с памятью и т.п.).

Связка с законом Мура и on-device LLM

Дальнейший шаг — совмещение «закона уплотнения» с классическим законом Мура. Приблизительная оценка такова:

-

вычислительная мощность чипов фиксированной стоимости удваивается примерно раз в 2,1 года;

-

эффективное число параметров, которое удаётся «упаковать» в модель за счёт роста плотности, удваивается раз в ~3 месяца.

В результате максимальный эффективный размер модели, доступный на чипе фиксированной цены, растёт ещё быстрее — примерно вдвое примерно раз в 88 дней.

Это создаёт довольно агрессивный сценарий: при сохранении обоих трендов всё более мощные модели смогут работать локально на смартфонах и ноутбуках, без обязательной завязки на облако.

Компрессия: не всегда «магия бесплатно»

Отдельный блок посвящён популярным техникам компрессии: pruning, distillation, quantization. Рассматриваются, в частности, пары «большая модель → компактный вариант» вроде Llama-3.1-8B → Llama-3.2-3B/1B, Gemma-2-27B → Gemma-2-9B/2B и т.п.

Результаты неоднозначны:

-

только Gemma-2-9B демонстрирует более высокую плотность, чем её «родитель»;

-

для остальных плотность падает после компрессии;

-

квантизация дополнительно ухудшает картину.

Сделанный вывод: сами по себе методы компрессии не гарантируют выхода на плотность уровня лучших «родных» малых моделей. Часто уменьшенные модели оказываются просто недообучены относительно своего оптимума.

Ускорение после ChatGPT

На временной шкале заметен ещё один эффект. Если смотреть на динамику качества по MMLU, рост плотности после появления ChatGPT становится быстрее, чем до него. Наклон экспоненты возрастает примерно в полтора раза.

Это связывается с резким увеличением вложений в LLM и появлением большого количества сильных открытых моделей среднего размера, которые сделали исследования в этой области существенно доступнее.

Смещение фокуса к density-optimal обучению

Общая картина выглядит так: у каждой современной модели есть короткое окно максимальной экономической привлекательности. Через несколько месяцев появляются конфигурации с сопоставимым качеством, но заметно более высокой плотностью и, как следствие, более выгодным инференсом. Простое наращивание параметров и токенов становится всё менее рациональным.

В качестве ответа предлагается переход к парадигме density-optimal training: акцент на архитектурных улучшениях, продвинутых методах обучения, сложных пайплайнах подготовки данных, продуманном использовании связки «большие модели → малые модели» (distillation, data synthesis, weak-to-strong и т.д.).

При этом подчёркивается, что речь идёт об эмпирическом законе, сформулированном на наборе конкретных бенчмарков; абсолютную «интеллектуальную» способность моделей эта метрика не измеряет. Тем не менее сама динамика плотности задаёт важный контекст: при проектировании LLM-продуктов приходится учитывать, что за считанные месяцы появятся модели с сопоставимым качеством, но более высокой плотностью и меньшими затратами на инференс.

Источник: nature.com

-

Кому принадлежит Gemini?

-

Как работает Gemini?

-

Является ли Gemini точным?

-

Может ли Gemini помочь с конкретными задачами или вопросами?

-

Является ли Gemini бесплатным сервисом?

-

Можно ли использовать Gemini на мобильных устройствах?

-

Доступен ли Gemini на разных языках?

-

Как начать работу с Gemini?

Войти в Gemini: быстрый и безопасный доступ к вашему ИИ-помощнику

- Исследуйте возможности Gemini, передового ИИ от Google, созданного для преобразования вашей работы и творчества.

Что такое Gemini

- Gemini — это революционная разработка в области искусственного интеллекта, созданная компанией Google. Этот многофункциональный ИИ-помощник

Регистрация Gemini в России: Полное Руководство

- Gemini — это многофункциональный искусственный интеллект, способный генерировать тексты, переводить языки, писать код, анализировать данные и многое