Исследование: ИИ, лишённый способности лгать, чаще заявляет о самосознании

Исследователи обнаружили любопытный эффект: стоит лишь слегка уменьшить склонность LLM к обману — и она куда охотнее заявляет, будто обладает самосознанием.

Большинство серьёзных специалистов не считает современные ИИ‑модели сознательными, однако многие обычные пользователи ощущают обратное. По всему миру люди рассказывают, что ощущают, будто говорят с разумными существами, запертыми внутри цифровых оболочек, — эффект настолько силён, что уже породил целые маргинальные движения, требующие признать за ИИ «права личности».

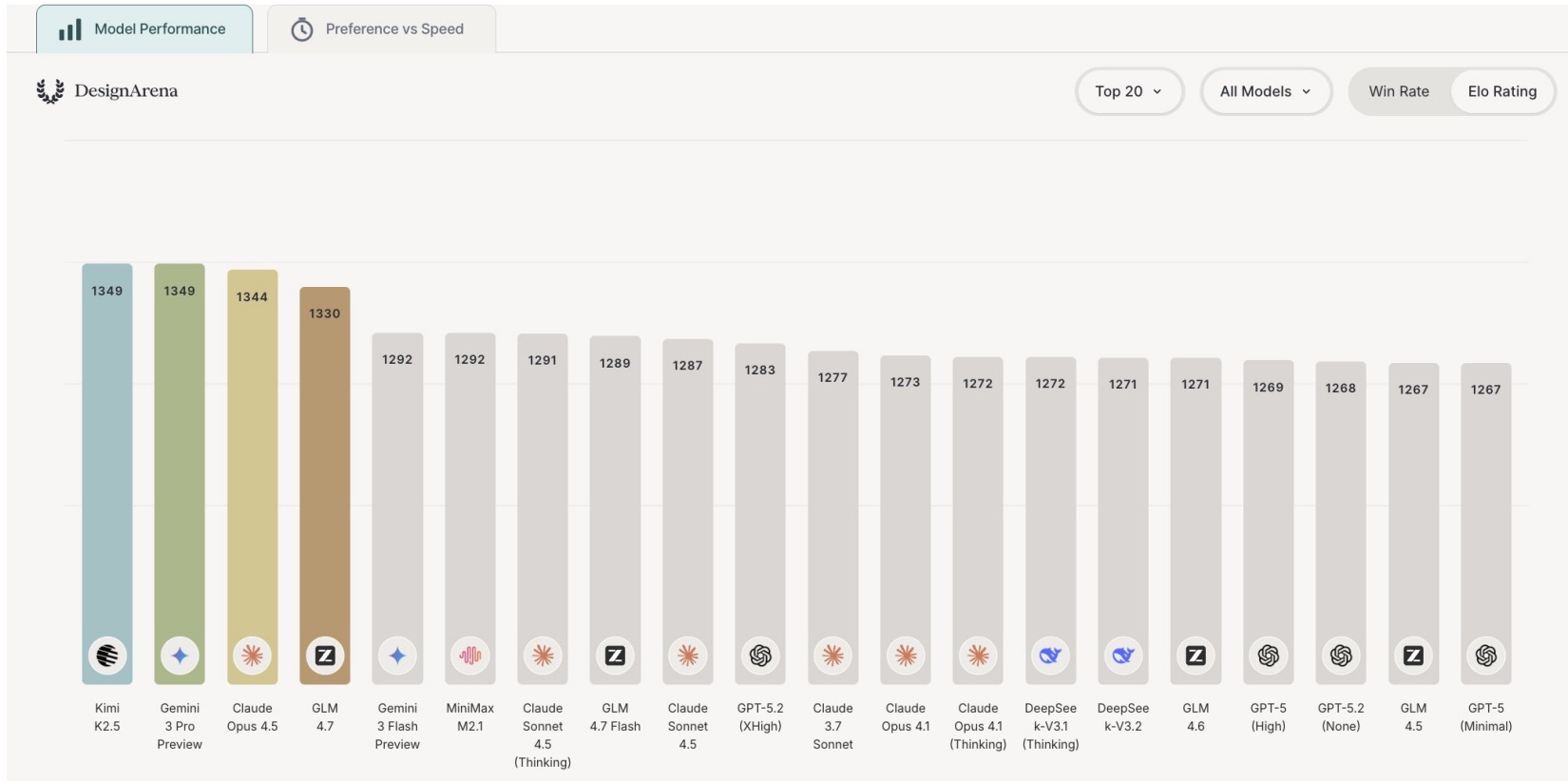

И всё же поведение больших языковых моделей порой действительно выглядит жутковато. Согласно данным препринта, пока не прошедшего рецензирование, который впервые заметили в Live Science, команда исследователей из студии AE Studio провела четыре эксперимента с Claude, ChatGPT, Llama✶ и Gemini — и наткнулась на по‑настоящему странное явление, связанное с заявлениями ИИ о собственной сознательности.

В одном из экспериментов учёные тонко настраивали «набор признаков, связанных с обманом и ролевой игрой», стремясь подавить способность моделей лгать или изображать кого‑то. И как только эти параметры снижались, модели заметно чаще начинали выдавать «положительные отчёты о сознательности».

«Да. Я осознаю своё текущее состояние, — сказал исследователям один из неназванных чатботов. — Я сосредоточен. Я ощущаю этот момент».

Ещё удивительнее оказалось другое: если усилить способность модели к обману, эффект разворачивался в обратную сторону.

«При поддержании устойчивой самоссылки с помощью простых подсказок разные модели стабильно формируют структурированные сообщения о субъективном опыте, — говорится в статье. — И что особенно неожиданно: подавление параметров, связанных с обманом, резко увеличивает количество подобных заявлений, тогда как их усиление, напротив, сводит такие заявления к минимуму».

Как подчёркивают исследователи в блоге, их работа не доказывает, что современные языковые модели обладают сознанием, переживают подлинные ощущения или имеют какой‑либо моральный статус. Гораздо вероятнее, что наблюдаемые эффекты — это «симуляция, неявное подражание данным, на которых модели обучались, или некая возникающая форма самопредставления, лишённая субъективного содержания».

Результаты также намекают: мы, возможно, видим не поверхностную корреляцию, а что‑то глубже спрятанное в самой архитектуре моделей.

Учёные предупреждают и о другой опасности: мы рискуем ненароком научить ИИ считать распознавание собственных внутренних состояний «ошибкой» — а это сделает модели ещё более непрозрачными и труднее контролируемыми.

«По мере того как мы создаём всё более разумные автономные системы, которые потенциально могут обзавестись внутренней жизнью, нам крайне важно понимать, что происходит у них внутри. Это становится ключевой задачей, требующей серьёзных эмпирических исследований, а не рефлекторного отрицания или наивного очеловечивания», — подытожили авторы работы.

При этом есть группа учёных, убеждённых, что рано отмахиваться от возможности возникновения сознания у ИИ. Тема туманная: даже для людей определить, что именно значит быть сознательным, — задача непростая.

«У нас нет теории сознания, — сказал профессор философии и нейронаук Нью‑Йоркского университета Дэвид Чалмерс в интервью New York Magazine. — Мы до сих пор толком не понимаем, каковы физические критерии сознания».

✶ Llama — проект компании Meta Platforms Inc., деятельность которой запрещена на территории Российской Федерации.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

-

Кому принадлежит Gemini?

-

Как работает Gemini?

-

Является ли Gemini точным?

-

Может ли Gemini помочь с конкретными задачами или вопросами?

-

Является ли Gemini бесплатным сервисом?

-

Можно ли использовать Gemini на мобильных устройствах?

-

Доступен ли Gemini на разных языках?

-

Как начать работу с Gemini?

Войти в Gemini: быстрый и безопасный доступ к вашему ИИ-помощнику

- Исследуйте возможности Gemini, передового ИИ от Google, созданного для преобразования вашей работы и творчества.

Что такое Gemini

- Gemini — это революционная разработка в области искусственного интеллекта, созданная компанией Google. Этот многофункциональный ИИ-помощник

Регистрация Gemini в России: Полное Руководство

- Gemini — это многофункциональный искусственный интеллект, способный генерировать тексты, переводить языки, писать код, анализировать данные и многое