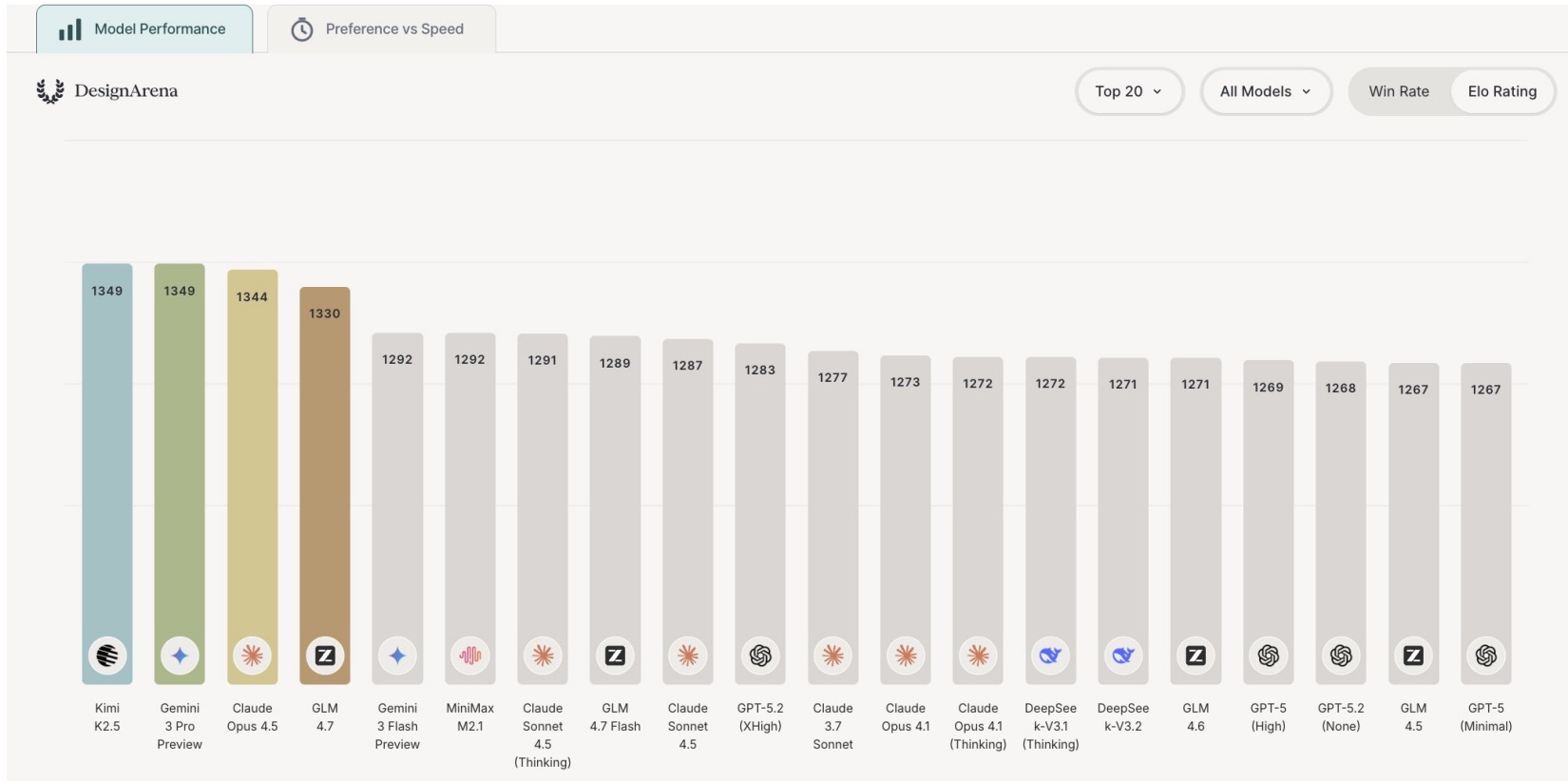

Claude Opus 4.5 стал лучшим в бенчмарке на реальные рабочие задачи

Компания Artificial Analysis представила GDPval-AA — собственную реализацию бенчмарка OpenAI на реальных рабочих задачах. Тест охватывает 44 профессии и 9 отраслей: модели создают презентации, заполняют таблицы Excel, пишут документы Word и даже рендерят видео. Лидером стал Claude Opus 4.5 с результатом 1426 Elo.

В топ-5 вошли Claude Opus 4.5, GPT-5 (1311 Elo), Claude Sonnet 4.5 (1291), а DeepSeek V3.2 и Gemini 3 Pro разделили пятое место с 1206 очками. Примечательно, что GPT-5.1 — более новая модель OpenAI — показала результат хуже предшественника. По данным Artificial Analysis, GPT-5.1 использует на 50% меньше токенов, но набрала на 67 Elo меньше, чем GPT-5. Оптимизация эффективности, судя по всему, ударила по качеству выполнения задач.

Artificial Analysis также протестировала готовые чат-приложения. Claude с Opus 4.5 Thinking снова оказался первым (1325 Elo), ChatGPT с GPT-5.1 — вторым (1129). Разрыв почти в 200 очков объясняется не только силой модели: Claude оказался единственным, кто создавал видео- и аудиофайлы. ChatGPT отказывался от таких задач, Perplexity сдавал скрипты вместо готовых продуктов и путал форматы файлов, Gemini выдавал PDF вместо запрошенных Word-документов, Kimi делал веб-порталы там, где просили простой Word, а Grok не справлялся с нужными форматами.

При этом лидерство Claude обходится дорого: прогон всего бенчмарка стоил $608. Для сравнения, GPT-5 обошелся в $167, а DeepSeek V3.2 — всего в $29. Последний стал единственной моделью, попавшей в "зеленый квадрант" графика цена/качество: топ-5 результат при стоимости в 20 раз ниже лидера.

P.S. Поддержать меня можно подпиской на канал "сбежавшая нейросеть", где я рассказываю про ИИ с творческой стороны.

-

Кому принадлежит Gemini?

-

Как работает Gemini?

-

Является ли Gemini точным?

-

Может ли Gemini помочь с конкретными задачами или вопросами?

-

Является ли Gemini бесплатным сервисом?

-

Можно ли использовать Gemini на мобильных устройствах?

-

Доступен ли Gemini на разных языках?

-

Как начать работу с Gemini?

Войти в Gemini: быстрый и безопасный доступ к вашему ИИ-помощнику

- Исследуйте возможности Gemini, передового ИИ от Google, созданного для преобразования вашей работы и творчества.

Что такое Gemini

- Gemini — это революционная разработка в области искусственного интеллекта, созданная компанией Google. Этот многофункциональный ИИ-помощник

Регистрация Gemini в России: Полное Руководство

- Gemini — это многофункциональный искусственный интеллект, способный генерировать тексты, переводить языки, писать код, анализировать данные и многое