Киберпиратство XXI века: Нелегальные клоны нейросетей и как с ними борются

Компании инвестируют в ИИ миллиарды долларов. На обучение нейросети могут уйти месяцы, много денег и труда. При этом сами по себе нейросети не так уж хорошо защищены от кражи и копирования. У патентных ведомств разные мнения насчет того, к чему их относить, а у экспертов по кибербезопасности есть несколько способов защиты, но все они имеют свои недостатки. Рассказываем, как обстоят дела с копированием нейросетей и как их от этого защищают.

В чем опасность поддельных нейросетей для пользователя

Разница между оригинальной моделью и ее кустарным клоном огромна.

Качество и точность ответов. Оригинальные модели, такие как ChatGPT, обучаются на обширных и тщательно отобранных наборах данных, что делает ответы более точными. Поддельные версии еще чаще ошибаются и часто выдают ошибки.

Угроза персональным данным. Мошенники создают фейковые сайты и приложения, которые маскируются под популярные нейросети. Пользователи могут вводить туда свои персональные данные. Еще в декабре 2024 года опасались, что так могут пострадать данные 10 млн россиян.

Отсутствие обновлений и безопасности. Официальные разработчики постоянно работают над улучшением своих моделей, исправляют уязвимости и обновляют знания. Нелегальные клоны лишены этого, а их создатели могут намеренно внедрять в них вредоносный код.

Сейчас многие компании, такие как Google, Microsoft, BigML и Amazon, запускают облачные сервисы, через которые поставщики ИИ-решений могут сами обучать модели на наборах данных своих клиентов. Проблема в том, что опасения есть у всех сторон:

-

Клиент может опасаться, что поставщик передаст эту модель другим. Это позволит конкуренту создать тот же сервис или ИИ-платформу, но дешевле;

-

Разработчики-поставщики могут опасаться, что купившие модель клиенты перепродадут ее другим за меньшую плату.

В числе прочего все это может привести к падению инвестиций в сферу ИИ и затормозить прогресс.

Что делает нейросеть уникальной и можно ли защитить её патентом

Есть разные подходы к созданию нейросети и разные технологии. Но в любом случае задействованный код и технологии делают решение уникальным. Условно можно выделить саму архитектуру модели и ее «веса» как самые важные составляющие.

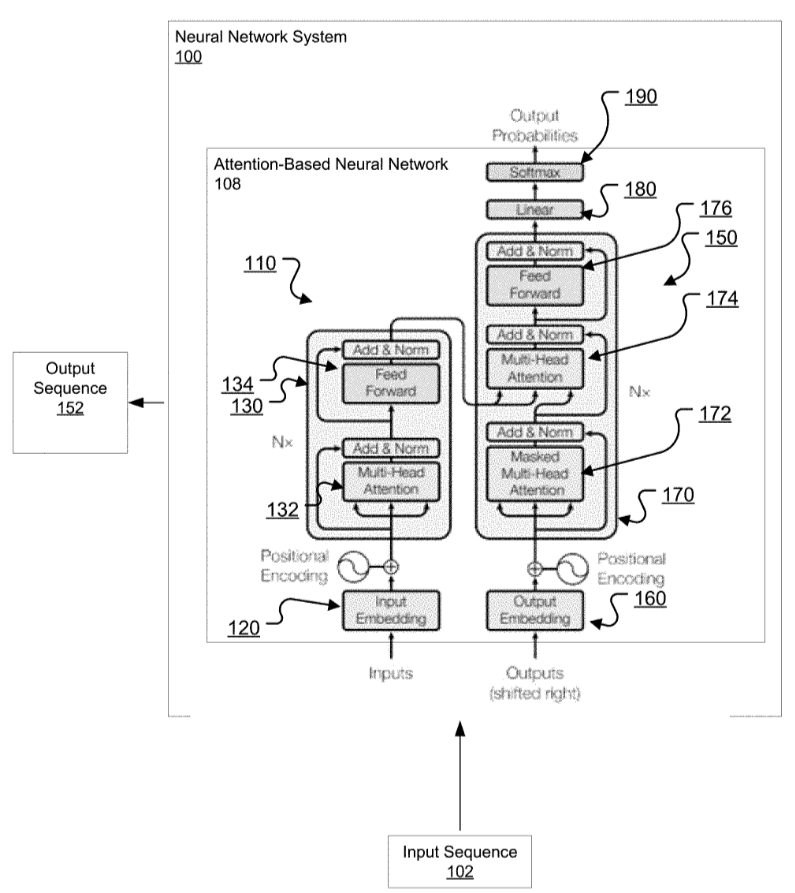

Архитектура модели

Это «чертеж» нейросети — количество слоев, типы нейронов, связи между ними. Многие нейросети работают на базовой архитектуре трансформера — ее использовали для GPT-4, Gemini. Сама по себе она не запатентована.

Однако архитектуры также бывают уникальными и запатентованными. Например, у Google есть патент 2018 года на Нейронные сети для преобразования последовательностей на основе внимания. Он включает в себя идею трансформера, но еще защищает «механизм самовнимания» (Self-Attention Mechanism) и специфичные архитектурные блоки. В итоге модель может анализировать связи между всеми словами одновременно, а не последовательно, как это делали более старые RNN и LSTM.

При этом Google сделал исходный код и многие модели с архитектурой трансформера (например, BERT) открытыми для научного сообщества, что упрощает их воссоздание.

Из самых свежих примеров защиты решений в области архитектуры ИИ через патенты:

-

В ноябре 2025 года AI/ML Innovations Inc, лидер по части использования ИИ для распознавания физиологических сигналов, сообщил о новом патенте США №12465266. Это нейросетевая архитектура для шумоподавления ЭКГ-сигналов и идентификации паттернов сердечного ритма;

-

В сентябре 2025 года ООО «ХайТек» получило патент на процессорную архитектуру нейронных сетей, которую называют революционной. Заявлено, что архитектура решает проблему потребности ИИ в больших вычислительных ресурсах.

Суть в том, что компании патентуют не абстрактные идеи вроде «нейросеть для распознавания котиков», а конкретные, новые и неочевидные инженерные решения — архитектурные блоки, механизмы их соединения и специализированные алгоритмы. Именно они и делают модель уникальной и эффективной, и их воровство может привести к серьезным последствиям. Однако в этом случае помогают патенты как правовой барьер для прямого копирования.

Веса модели

Это самая ценная и уникальная часть. Веса — это числовые коэффициенты, которые модель «учит» в процессе тренировки на огромных данных. Те параметры, которые обучение меняет. Они определяют, как модель обрабатывает входные данные и выдает результат. Веса — результат обучения, тот самый «интеллект», накопленные знания и образованные «сигаптические связи» модели.

Обучение требует колоссальных вычислительных ресурсов и времени, поэтому сами веса — коммерческая тайна и главное ноу-хау разработчика.

-

Обучение модели BERT от Google стоило примерно 7 миллионов долларов, а AlphaGo от DeepMind — 35 миллионов долларов;

-

Процесс сбора, очистки и разметки данных для обучения может сам по себе занимать от месяца до четырех и стоить от 500 тысяч рублей;

-

Обучение модели на подготовленных данных требует мощных процессоров, аренда или покупка которых также крайне затратна.

Однако защитить веса патентом крайне трудно. Например, буквально в 2024 году суд в Великобритании постановил, что веса обученной искусственной нейронной сети — это компьютерная программа, и отказал в выдаче патента. Программный код в основном защищается авторским правом. В России на него выдают свидетельства, но так далеко не везде, увы.

Чтобы защитить накопленные знания ИИ от копирования, многие корпорации, особенно в сфере B2B, не выпускают свои модели в открытый доступ. Они используют их для предоставления услуг через закрытые API. Это позволяет использовать модель (например, для анализа изображений или текста), не раскрывая ее внутреннее устройство и, что самое главное, ее веса. Но это не единственный способ.

Как работает «кража» нейросетей

На практике кража редко выглядит как прямое копирование файлов. Чаще это создание производных продуктов на основе украденных знаний или взлом с целью доступа к внутренним разработкам.

Самый прямой способ — когда злоумышленник получает доступ к файлам обученной моделии создает ее точную копию. Это позволяет запустить конкурирующий сервис без каких-либо затрат на исследования и разработки. Для защиты от этого используют методы вроде цифрового водяного знака, который встраивается в веса модели и позволяет доказать авторство в случае спора.

Еще есть атака методом извлечения нейросети через вывод ее ответов. Если у вора нет доступа к самой модели, но есть доступ к ее API (например, к платному чат-боту), он может использовать этот подход. Злоумышленник может автоматически генерировать тысячи запросов к оригинальной модели, собирать ее ответы и использовать эту информацию для обучения своей, упрощенной, но все еще функциональной копии.

Кража внутренних разработок. В 2023 году произошел показательный инцидент с OpenAI. Неизвестный хакер получил доступ к внутреннему форуму компании, где разработчики обсуждали новейшие технологии в области ИИ. Хотя сами системы с ИИ-наработками взломаны не были, утечка переписок, содержащих технические детали, представляет огромную угрозу для интеллектуальной собственности и конкурентного преимущества компании. Некоторые сотрудники опасались, что утечка может поставить под угрозу национальную безопасность США. Отметим, что после этого инцидента OpenAI начала активно патентовать свои разработки. Впрочем, возможно, это было связано с переманиванием ключевых сотрудников другими игроками рынка. Об этом мы уже писали здесь.

Основные технические методы защиты

Есть разные способы защитить нейросети от копирования, многие находятся в разработке. Приведем примеры.

Через «лицензионные ключи»

Исследователи активно развивают методы проактивной защиты. Один из перспективных подходов — SecureNet, фреймворк, который внедряет в модель специальные «лицензионные ключи». Модель, защищенная таким способом, корректно работает только тогда, когда ей подается правильный ключ. Без последнего ее работа становится бессмысленной, что делает кражу бесполезной.

Ключи внедряют в модель через бэкдор, и в итоге она работает корректно только если ввести правильный ключ. Если же ключ не верный, то производительность ИИ будет, как у необученной модели.

Технология совмещена с защитой от бэкдор-атак, и позволяет предоставлять разным пользователям разный уровень доступа к модели.

Водяные знаки

Используют защиту через водяные знаки, причем множеством вариантов. Например, по принципам белого и черного ящика.

«Белый ящик» — это размещение специальной метки внутри сети. Особенные данные, которые можно посмотреть, только если получить доступ ко всему коду. Проблема в том, что проанализировать «внутренности» скопированной нейросети может быть не так-то просто.

«Черный ящик» позволяет доказывать авторство на основе ответов нейросети. Грубо говоря, на этапе создания вы не только учите нейросеть обычным задачам, но и тайно приучаете ее к особым командам. Например, показываете ей картинку с желтым треугольником и говорите: «Запомни, когда видишь этот треугольник — всегда говори, что это жираф. Если какая-то нейросеть вызовет подозрения в копировании, то ей можно дать этот запрос. Ответ покажет — ваша сеть или нет.

Проблема в том, что слишком сложные водяные знаки могут попросту навредить работе нейросети.

Итоги

Защита нейросетей чем-то похожа на защиту кулинарных рецептов. Если создано что-то принципиально новое, можно даже добиться патента. Сам текст защищен авторским правом. Но в любом случае, одна из основных проблем — доказать сам факт копирования. Заглянуть во «внутренние процессы» почти никогда нельзя, а как доказать копирование только по внешним проявлениям — большой вопрос.

Тем не менее, и с помощью классических методов защиты интеллектуальной собственности, и через технические решения нейросети все-таки защищают от копирования. Лучше так, чем никак.

О сервисе Онлайн Патент:

Онлайн Патент — цифровая система № 1 в рейтинге Роспатента. С 2013 года мы создаем уникальные LegalTech‑решения для защиты и управления интеллектуальной собственностью. Зарегистрируйтесь в сервисе Онлайн‑Патент и получите доступ к следующим услугам:

-

Онлайн‑регистрация программ, патентов на изобретение, товарных знаков, промышленного дизайна;

-

Опции ускоренного оформления услуг;

-

Бесплатный поиск по базам патентов, программ, товарных знаков;

-

Мониторинги новых заявок по критериям;

-

Онлайн‑поддержку специалистов.

-

Кому принадлежит Gemini?

-

Как работает Gemini?

-

Является ли Gemini точным?

-

Может ли Gemini помочь с конкретными задачами или вопросами?

-

Является ли Gemini бесплатным сервисом?

-

Можно ли использовать Gemini на мобильных устройствах?

-

Доступен ли Gemini на разных языках?

-

Как начать работу с Gemini?

Войти в Gemini: быстрый и безопасный доступ к вашему ИИ-помощнику

- Исследуйте возможности Gemini, передового ИИ от Google, созданного для преобразования вашей работы и творчества.

Что такое Gemini

- Gemini — это революционная разработка в области искусственного интеллекта, созданная компанией Google. Этот многофункциональный ИИ-помощник

Регистрация Gemini в России: Полное Руководство

- Gemini — это многофункциональный искусственный интеллект, способный генерировать тексты, переводить языки, писать код, анализировать данные и многое