Маленькая модель обыграла большие: почему Nanbeige4-3B меняет правила игры

В ноябре вышла модель Nanbeige4-3B-25-11 (а 6 декабря они выложили статью об обучении на arxiv). Её размер всего лишь 3 миллиарда параметров. Это почти в 100 раз меньше, чем GPT-4, и даже меньше, чем большинство открытых моделей.

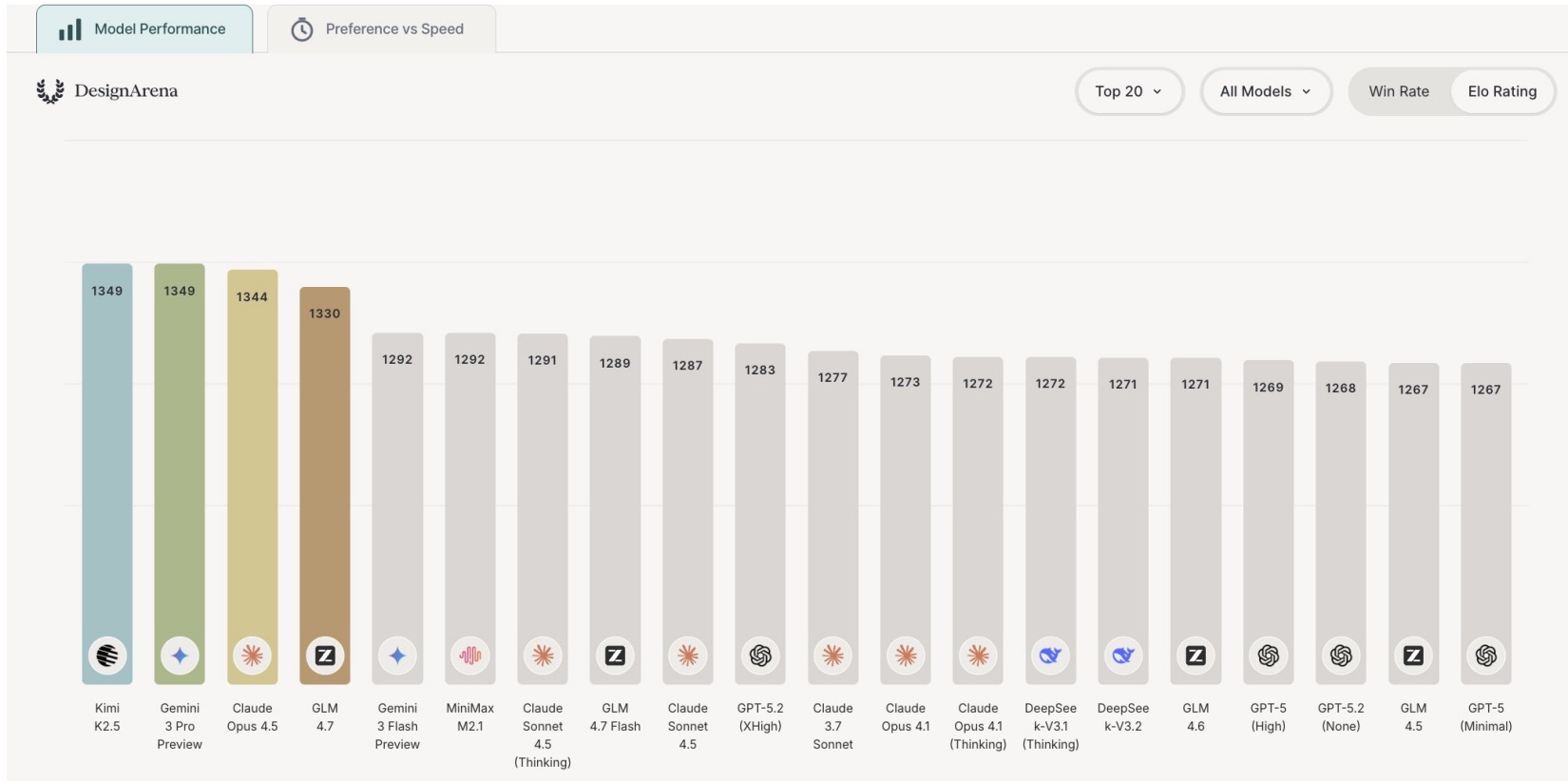

Но вот парадокс: на тестах она достигает показателей выше, чем модели в 10 раз больше, а на бенчмарке WritingBench и вовсе держится на уровне проприетарных моделей занимая место между Gemini-2.5-Pro и Deepseek-R1-0528.

В своей предыдущей публикации я уже затрагивал тему того, что качество обучающих данных важнее, чем их количество. Данная модель этому очередное подтверждение.

Что произошло: цифры

Давайте сначала просто посмотрим на результаты.

|

Тест |

Nanbeige 3B |

Qwen 4B |

Qwen 8B |

Qwen 32B |

|---|---|---|---|---|

|

Математика (AIME 2025) |

85.6 |

81.3 |

67.3 |

72.9 |

|

Наука (GPQA) |

82.2 |

67.2 |

62.0 |

68.7 |

|

Вызов функций (BFCL-V4) |

53.8 |

44.9 |

42.2 |

47.9 |

Результаты Nanbeige 3B лучше по всем бенчмаркам и она даже опережает модель в 32B параметров, которая в 10 раз больше.

Почему это оказалось возможно? Потому что разработчики Nanbeige сделали не очередную попытку усилить модель на большем датасете. Они вместо этого сделали пр��вильно 5 следующих вещей.

Хитрость 1: Качество данных вместо объема

Интернет - помойка. 90% текстов либо бесполезны, либо откровенно вредны для обучения модели. Андрей Карпатый уже озвучивал это в своих рассуждениях о прогрессе к достижению AGI.

Стандартный подход: Собираются огромные датасеты, набирается 100 триллионов токенов, проводится какая-то общая валидация и все это скармливается модели.

Подход Nanbeige: Собрали данные → отфильтровал по 20 критериям (информационная плотность, логичность, грамотность) → сравнили с базой хороших примеров → оставили только самое лучшее.

Результат: 23 триллиона чистых проверенных токенов. Не 100, не 50, а 23. Но ценность каждого токена в датасете значительно выше.

Просто для аналогии: если вы хотите выучить язык, лучше прочитать одну хорошую книгу 5 раз, чем 5 плохих книг по одному разу.

Хитрость 2: График обучения важнее, чем кажется

Учебные материалы были разбиты по сложности.

Разумный студент: сначала читает простой учебник, потом переходит на более сложный материал.

Качественная модель: сначала обучается на смешанных данных, потом всё больше и больше на высококачественных.

Разработчики внедрили FG-WSD (Fine-Grained Warmup-Stable-Decay) - расписание обучения, которое постепенно повышает долю качественных данных.

|

Этап |

Объем токенов |

Learning Rate |

Данные |

|---|---|---|---|

|

Разминка |

0.1T |

0 → 4.5e-4 |

- |

|

Разнообразие |

12.4T |

4.5e-4 |

Medium + High quality |

|

Качество |

6.5T |

4.5e-4 |

Только top 10% |

|

Распад |

4T |

4.5e-4 → 1.5e-6 |

Финализация |

На бенчмарках это дало в среднем +10% к результатам по сравнению с обычным методом WSD.

Хитрость 3: Научить модель объяснять, а не просто знать ответ

Модель может знать правильный ответ, но по неправильным причинам. Это плохо, потому что:

-

Она не сможет адаптироваться к похожим задачам

-

Она не сможет объяснить своё решение

-

Её логика будет хрупкой

Как они это исправили:

-

Модель решает задачу (несколько вариантов)

-

Берётся лучший ответ, проверяется логика

-

Автоматически восстанавливается цепь рассуждений, которая привела к ответу

Это как если бы вы сначала решили задачу быстро, потом переписали решение аккуратно, чтобы было ясно, как вы к нему пришли.

Результат: 16% прирост на тестах "общего качества" без потерь на reasoning.

Хитрость 4: Обучение у "учителя" методом DPD

У Nanbeige есть большая сильная модель (Nanbeige3.5-Pro). Они заставили маленькую модель учиться, наблюдая, как большая решает задачи.

Но не просто копировать ответы как это обычно делается при дистилляции, а пытаться копировать правильный процесс мышления.

Как это работает:

-

Большая модель решает 1000 задач (несколько вариантов на каждую)

-

Маленькая модель смотрит на варианты и учится:

-

На хороших ответах: "вот так надо думать"

-

На плохих ответах: "вот так думать не надо"

-

Результат: +30% к производительности на некоторых тестах (особенно на function/tool calling).

Хитрость 5: "Поощрение" за правильность

После всего выше описанного они использовали ещё один метод - reinforcement learning (RL). Но не на общем датасете, а на трёх специализированных:

Математика & наука

-

Модель решает задачу

-

Проверяющая программа использует Python для валидации

-

Если правильно → модель получает "поощрение"

Программирование

-

Модель пишет код

-

Код автоматически тестируется

-

Если тесты проходят → поощрение

Общение с людьми

-

Модель генерирует ответ

-

Экспертная система оценивает качество

-

Лучшие ответы используются для обучения

Важный момент: примеры выбирались не случайно. Брали только те, что сложноваты, но решаемы (10–90% сложности). Тривиальные примеры и невозможные были пропущены.

Результат: Стабильное улучшение по всем направлениям без "схлопывания" на узких задачах.

Что это значит практически?

Модель работает на обычном оборудовании:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained(

'Nanbeige/Nanbeige4-3B-Base',

use_fast=False,

trust_remote_code=True

)

model = AutoModelForCausalLM.from_pretrained(

'Nanbeige/Nanbeige4-3B-Base',

torch_dtype='auto',

device_map='auto',

trust_remote_code=True

)

prompt = "Столица России это"

input_ids = tokenizer(prompt, return_tensors='pt').input_ids

output_ids = model.generate(input_ids.to('cuda'))

resp = tokenizer.decode(output_ids[0][len(input_ids[0]):], skip_special_tokens=True)

print(resp)

И вот у вас есть reasoning-модель на 8Гб памяти (если использовать BF16, Q4 требует всего 2,5Гб). Можно использовать LMStudio для запуска GGUF версий без заморочек.

Плюсы:

-

Работает локально (можно использовать на чувствительных данных)

-

Быстрая инференция (до 3 раз быстрее 8B моделей)

-

Поддерживает tool calling (можно делать агентов)

-

64K контекст (можно работать с большими текстами)

-

Open-source (можно дообучить под свои задачи)

-

По моим тестам и в Q8, и в Q4 квантизации вполне хорошо придерживается русского языка, как в процессе размышлений, так и при ответе

На что обратить внимание

Это не панацея.

✗ На некоторых узких задачах 32B модели её обыгрывают

✗ Может ошибаться (как и все AI)

✗ Н�� этических вопросах может быть странной о чем предупреждают авторы

Но в целом - это серьёзный результат, который переопределяет, что возможно в масштабе 3B параметров.

Итоги

Nanbeige4-3B доказывает:

-

Размер модели ≠ её качество

-

Правильное обучение важнее, чем масштабирование

-

Маленькие модели могут быть практичны для реальных задач

Где скачать:

P.S. Модель была обучена в Boss Zhipin (компания из Китая, которая занимается HR-технологиями). Но открыли её для всех. Это редко и хорошо.

-

Кому принадлежит Gemini?

-

Как работает Gemini?

-

Является ли Gemini точным?

-

Может ли Gemini помочь с конкретными задачами или вопросами?

-

Является ли Gemini бесплатным сервисом?

-

Можно ли использовать Gemini на мобильных устройствах?

-

Доступен ли Gemini на разных языках?

-

Как начать работу с Gemini?

Войти в Gemini: быстрый и безопасный доступ к вашему ИИ-помощнику

- Исследуйте возможности Gemini, передового ИИ от Google, созданного для преобразования вашей работы и творчества.

Что такое Gemini

- Gemini — это революционная разработка в области искусственного интеллекта, созданная компанией Google. Этот многофункциональный ИИ-помощник

Регистрация Gemini в России: Полное Руководство

- Gemini — это многофункциональный искусственный интеллект, способный генерировать тексты, переводить языки, писать код, анализировать данные и многое