Claude Opus 4.5: как Anthropic сделала флагманскую модель в 3 раза дешевле и при этом умнее

24 ноября 2025 года Anthropic выстрелила релизом Claude Opus 4.5 — модели, которая переписывает правила игры для всех, кто использует LLM в production. Главная фишка? Цена упала в 3 раза, а качество выросло. Звучит как маркетинг, но цифры говорят сами за себя.

Разбираем, что реально изменилось, смотрим независимые бенчмарки и прикидываем, сколько это сэкономит вашей команде.

TL;DR для тех, кто спешит

? Цена: $5/1M input tokens (было $15) — снижение в 3 раза

⚡ Скорость: задачи, на которые уходило 2 часа, решаются за 30 минут

? Качество: 80.9% на SWE-bench (лучше GPT-4 и Gemini)

?️ Безопасность: в 4.6 раза устойчивее к prompt injection, чем GPT-5.1

? Автономность: работает 30+ минут без вашего участия

? Экономия токенов: 48-76% при том же качестве

Если вы используете GitHub Copilot, Cursor или любой другой AI-помощник для кода — вы уже почувствуете разницу.

Что вообще произошло?

Anthropic не просто обновила модель — они переосмыслили архитектуру с нуля. Обычно апдейты дают либо прирост качества, либо снижение цены. Здесь получилось и то, и другое одновременно.

Сравнение с предыдущей версией

Параметр Opus 4.1 Opus 4.5 Изменение

Input price $15/1M $5/1M ↓ 3x

Output price $75/1M $25/1M ↓ 3x

SWE-bench 74% 80.9% ↑ 9%

Context window 200K 200K =

Автономная работа ~15 мин 30+ мин ↑ 2x

Спойлер: На внутреннем техническом экзамене Anthropic для инженеров Opus 4.5 обошёл всех кандидатов-людей. Да, вы правильно поняли — всех.

Главная фишка: параметр effort

Это то, чего не хватало другим моделям. Вы можете явно контролировать, насколько глубоко модель должна думать над задачей.

python

import anthropic

client = anthropic.Anthropic(api_key="your_api_key")

Быстрый ответ для документации

response_low = client.messages.create(

model="claude-opus-4-5-20251101",

effort="low", # ? Быстро и дешево

messages=[{"role": "user", "content": "Напиши docstring"}]

)

Глубокий анализ для security review

response_high = client.messages.create(

model="claude-opus-4-5-20251101",

effort="high", # ? Максимальная точность

messages=[{"role": "user", "content": "Найди уязвимости"}]

)

Что дает каждый уровень?

low → быстрые ответы, минимум токенов

Для: документация, простые подсказки, brainstorming

medium → качество как у Sonnet 4.5, но экономия 76% токенов

Для: генерация кода, рефакторинг, большинство задач

high → превосходит Sonnet 4.5 на 4.3%, экономия 48% токенов

Для: security audit, архитектурные решения, критичные задачи

Практический смысл: вы буквально крутите регулятор "скорость/качество/цена" в зависимости от задачи. Раньше так не умела ни одна модель.

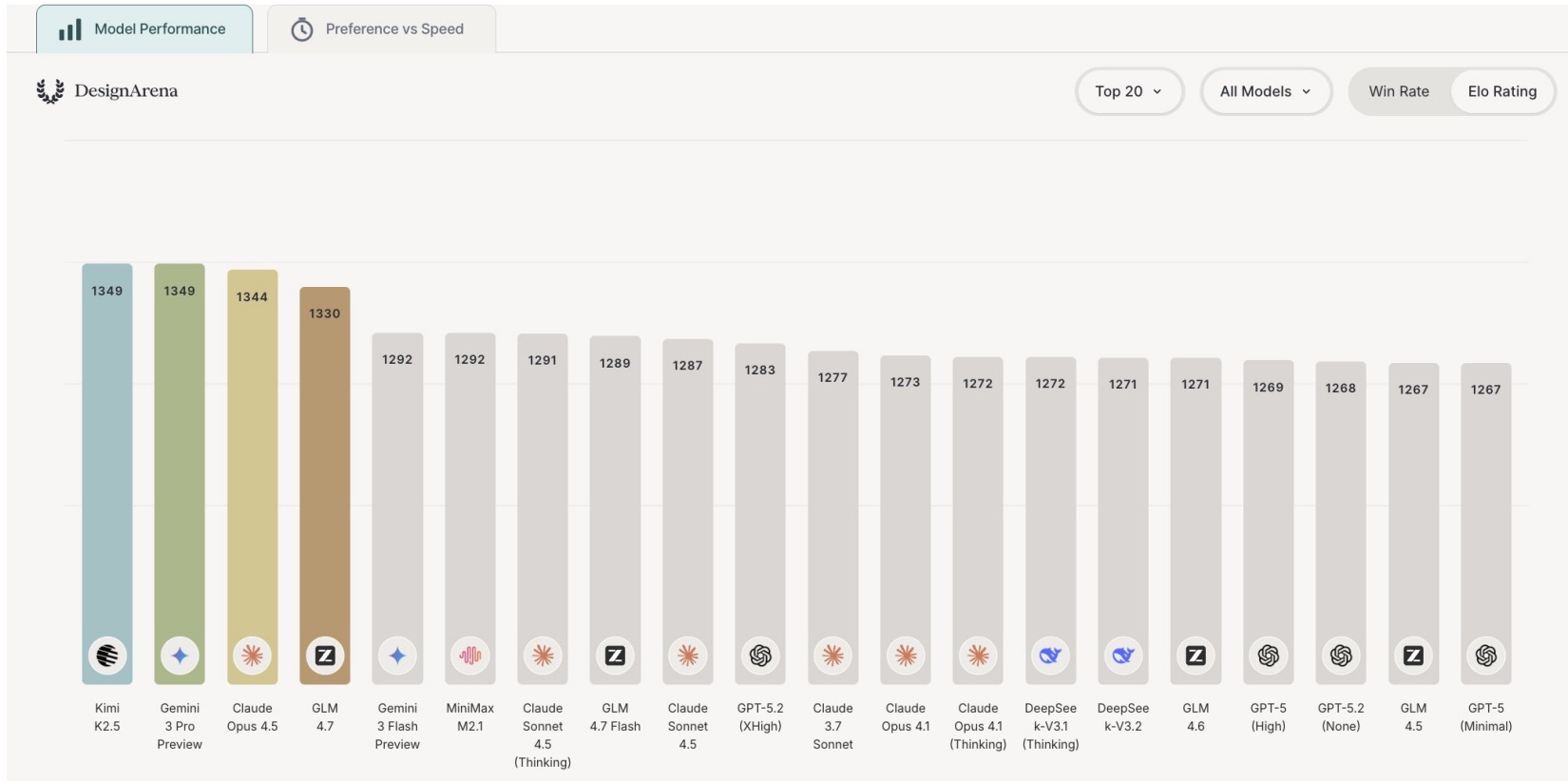

Бенчмарки: где Opus 4.5 рвёт конкурентов

Независимые тесты от Vellum AI дают чёткую картину.

? Кодинг и Software Engineering

SWE-bench Verified (решение реальных багов из GitHub issues)

text

Claude Opus 4.5 ████████████████████ 80.9%

GPT 5.1 ███████████████████ 76.3%

Gemini 3 Pro ███████████████████ 76.2%

Terminal-Bench (работа с командной строкой и CLI)

text

Claude Opus 4.5 ███████████████ 59.3%

Gemini 3 Pro █████████████ 54.2%

GPT 5.1 ███████████ 47.6%

? Важно: Opus 4.5 показывает не просто более высокий процент, но и стабильнее работает на сложных multi-file refactoring задачах, где другие модели начинают "плыть".

? Reasoning и абстрактное мышление

ARC-AGI-2 (визуальные головоломки без вербальных подсказок)

text

Claude Opus 4.5 ███████████████████ 37.6%

Gemini 3 Pro ████████████ 31.1%

GPT 5.1 ███████ 17.6%

Это в 2.1 раза лучше, чем у GPT-5.1. Для задач, где нужен нестандартный подход (дебаг нетривиальных багов, оптимизация алгоритмов), это критично.

?️ Security: устойчивость к атакам

Gray Swan Prompt Injection Test (процент успешных взломов)

text

Claude Opus 4.5 ██ 4.7% ✅

Gemini 3 Pro ████████ 12.5%

GPT 5.1 ██████████████████ 21.9% ⚠️

В 4.6 раза устойчивее, чем GPT-5.1. Если ваш LLM обрабатывает user input в production, это критический параметр безопасности.

⚔️ Где конкуренты впереди

Будем честны: Opus 4.5 не лидер во всём.

Multimodal tasks (MMMU):

GPT 5.1: 85.4% ✅

Claude Opus 4.5: 80.7%

Long-term planning (Vending-Bench 2):

Gemini 3 Pro: $5,478 ✅

Claude Opus 4.5: $4,967

Вывод: Для vision и long-horizon planning задач лучше брать GPT-4V или Gemini. Для кода и reasoning — Opus 4.5 рулит.

Практика: 5 реальных кейсов

-

? Автоматический code review Задача: Ревьюить PR в крупной кодовой базе без участия senior'ов.

python

def review_pull_request(pr_diff, codebase_context):

"""Автоматический review с глубоким анализом"""

client = anthropic.Anthropic(api_key="your_api_key")

response = client.messages.create(

model="claude-opus-4-5-20251101",

max_tokens=2048,

effort="high", # ⚠️ Критичная задача

messages=[{

"role": "user",

"content": f"""

Контекст проекта:

{codebase_context}

Изменения в PR:

{pr_diff}

Найди:

1. ? Потенциальные баги и edge cases

2. ?️ Нарушения архитектурных паттернов

3. ⚡ Проблемы производительности

4. ? Security concerns

5. ✨ Предложения по улучшению

"""

}]

)

return response.content

Результаты в production:

✅ На 20% больше потенциальных багов vs GPT-4

✅ Снижение false positives на 15%

✅ Экономия 5-7 часов в неделю на команду из 10 человек

Реальный отзыв: GitHub Copilot интегрировал Opus 4.5 и сократил расход токенов вдвое при том же качестве подсказок.

-

✅ Генерация unit-тестов Задача: Покрыть тестами legacy код, на который у команды не хватает времени.

python

def generate_comprehensive_tests(source_code, framework="pytest"):

"""Генерация полного test suite с edge cases"""

client = anthropic.Anthropic(api_key="your_api_key")

response = client.messages.create(

model="claude-opus-4-5-20251101",

max_tokens=4096,

effort="medium", # ⚖️ Баланс качества и цены

messages=[{

"role": "user",

"content": f"""

Исходный код:

```

{source_code}

```

Создай comprehensive test suite для {framework}:

✓ Покрытие всех public методов

✓ Edge cases и boundary conditions

✓ Mocking внешних зависимостей

✓ Fixtures для test data

✓ Parametrized tests где применимо

"""

}]

)

return response.content

Метрики из реального проекта:

? Test coverage: с 45% до 87%

? Стоимость для модуля из 500 LOC: ~$0.15

⏱️ Время: 5-10 минут vs 2-3 часа руками

-

? API документация на автомате Задача: Генерировать документацию из кода (и не тратить на это время devops).

python

def generate_api_docs(code, existing_docs=None):

"""Автогенерация документации с примерами"""

client = anthropic.Anthropic(api_key="your_api_key")

response = client.messages.create(

model="claude-opus-4-5-20251101",

effort="low", # ? Документация не требует deep reasoning

messages=[{

"role": "user",

"content": f"""

Код: {code}

Создай API docs:

- Краткое описание функциональности

- Parameters с типами и дефолтами

- Return values

- Примеры использования (3-4 кейса)

- Возможные exceptions

"""

}]

)

return response.content

Экономика:

effort=low → экономия до 70% токенов vs effort=high

Проект с 50 endpoints → $2-3 за полную документацию

Notion AI на базе Opus 4.5 создает тексты, готовые к публикации с первого раза

-

? Валидация infrastructure as code Задача: Проверять Terraform/Kubernetes конфиги перед деплоем.

python

def validate_infrastructure(tf_code, requirements):

"""Security audit + cost optimization для IaC"""

client = anthropic.Anthropic(api_key="your_api_key")

response = client.messages.create(

model="claude-opus-4-5-20251101",

effort="high", # ? Production infrastructure — критично

messages=[{

"role": "user",

"content": f"""

Terraform конфигурация:

```

{tf_code}

```

Требования: {requirements}

Проверь:

1. ? Security (IAM, network policies, encryption at rest)

2. ? Cost optimization (overprovisioning, unused resources)

3. ✅ Соответствие requirements

4. ⚠️ Потенциальные проблемы в production

5. ✨ Рекомендации по улучшению

"""

}]

)

return response.content

Кейс: В одной команде Opus 4.5 выявил misconfigured IAM роли, которые давали излишние права. Потенциальная security hole закрыта до деплоя.

-

⚡ Оптимизация SQL-запросов Задача: Ускорить медленные запросы без найма DBA.

python

def optimize_slow_query(query, schema, execution_stats):

"""Анализ и оптимизация SQL с explain plan"""

client = anthropic.Anthropic(api_key="your_api_key")

response = client.messages.create(

model="claude-opus-4-5-20251101",

effort="high",

messages=[{

"role": "user",

"content": f"""

Медленный запрос (execution time: 15s):

```

{query}

```

Schema: {schema}

Execution plan: {execution_stats}

Предложи:

1. Оптимизированную версию запроса

2. Необходимые индексы (с DDL)

3. Альтернативные подходы (materialized views, partitioning)

4. Анализ explain plan

"""

}]

)

return response.content

? Экономика: считаем выгоду в долларах

Кейс 1: Генерация REST API endpoint

Задача: Написать endpoint с валидацией, обработкой ошибок, тестами (~200 LOC)

Модель Input Output Стоимость

Opus 4.5 1500 tokens 3000 tokens $0.0825 ✅

Opus 4.1 1500 tokens 3000 tokens $0.2475

Экономия 67%

При 50 запросах в день:

Opus 4.5: $123.75/месяц

Opus 4.1: $371.25/месяц

Вы экономите $247.5/месяц или $2970/год

Кейс 2: Code review (500 LOC per PR)

Модель Стоимость за PR 20 PR/неделю

Opus 4.5 $0.09 $7.2/месяц ✅

Opus 4.1 $0.27 $21.6/месяц

Кейс 3: ROI для команды из 10 разработчиков

Типичное использование:

Code generation: 50 запросов/день

Code review: 20 PR/неделю

Документация: 5 часов/неделю автоматизации

Debugging: 30 запросов/день

Модель Месячная стоимость Годовая

Claude Opus 4.5 $200-250 $2400-3000 ✅

Claude Opus 4.1 $650-750 $7800-9000

GPT-4 Turbo $400-500 $4800-6000

Экономия при переходе с Opus 4.1 → Opus 4.5:

$400-500/месяц

$4800-6000/год

? Это зарплата джуна в регионах или 20-30% стоимости одного разработчика в команде.

? AI-агенты: как Opus 4.5 работает автономно

Самая недооценённая фича — способность работать 30+ минут без вашего участия.

Раньше (любая другая модель):

text

Вы: "Найди баг в этом коде"

AI: "В какой части кода искать?"

Вы: "В модуле авторизации"

AI: "Какие симптомы бага?"

Вы: "Пользователи не могут залогиниться"

AI: "Какие логи есть?"

Вы: вставляет логи

AI: наконец-то начинает анализировать

Сейчас (Opus 4.5):

text

Вы: "Найди баг в этом коде"

AI: сам анализирует код → запускает тесты → ��мотрит логи → находит проблему → предлагает фикс → верифицирует решение

"Нашёл: race condition в модуле auth, вот патч..."

Архитектура multi-agent системы

text

┌─────────────────────────────────────┐

│ Coordinator (Opus 4.5, high) │

└──────────┬──────────────────────────┘

│

┌─────┴─────┬────────┬──────────┐

│ │ │ │

▼ ▼ ▼ ▼

┌─────────┐ ┌────────┐ ┌──────┐ ┌────────┐

│Code Gen │ │Testing │ │Docs │ │Review │

│(high) │ │(medium)│ │(low) │ │(high) │

└─────────┘ └────────┘ └──────┘ └────────┘

Как это работает:

python

tools = [

{

"name": "execute_code",

"description": "Запустить Python код в sandbox",

"input_schema": {

"type": "object",

"properties": {

"code": {"type": "string"}

}

}

},

{

"name": "search_docs",

"description": "Искать в документации",

"input_schema": {

"type": "object",

"properties": {

"query": {"type": "string"}

}

}

}

]

response = client.messages.create(

model="claude-opus-4-5-20251101",

max_tokens=4096,

tools=tools,

messages=[{

"role": "user",

"content": "Debug failing tests, find root cause, propose fix"

}]

)

Agent сам:

1. Анализирует код теста ✓

2. Запускает тест для воспроизведения ✓

3. Ищет релевантную документацию ✓

4. Предлагает исправление ✓

5. Проверяет, что фикс работает ✓

Результаты из практики:

Агенты на Opus 4.5 достигают пиковой производительности за 4 итерации

Другим моделям нужно 10+ попыток

В мультиагентных системах: +15% производительности

⚠️ Ограничения (о которых не расскажут в маркетинге)

Давайте честно: Opus 4.5 — не серебряная пуля.

-

? Hallucinations никуда не д��лись Модель может генерировать уверенно звучащий, но неверный код.

Что делать:

python

❌ ПЛОХО

generated_code = opus_generate_code(task)

deploy_to_production(generated_code) # ?

✅ ХОРОШО

generated_code = opus_generate_code(task)

run_tests(generated_code) # Проверка работоспособности

run_static_analysis(generated_code) # Проверка стиля и безопасности

human_review(generated_code) # Финальная проверка

deploy_to_production(generated_code)

2. ? Context window 200K — много, но не бесконечно

Для очень больших кодовых баз (100K+ LOC) этого мало.

Решение:

Используйте RAG (Retrieval-Augmented Generation) для релевантных частей

Semantic chunking кодовой базы

Hierarchical summarization для архитектурного контекста

-

? Multimodal слабее GPT-4V Если нужно работать с:

Диаграммами архитектуры

UI mockups

Графиками и дашбордами

Гибридный подход:

GPT-4V для vision tasks

Opus 4.5 для code/text

Переключайтесь между ними в зависимости от задачи

-

⏱️ Latency при effort=high Высокий effort может давать 30-60 секунд latency для сложных запросов.

Решения:

python

1. Async API

async def review_code_async(code):

response = await client.messages.create(

model="claude-opus-4-5-20251101",

effort="high",

messages=[...]

)

2. Кэширование результатов

@cache(ttl=3600)

def get_code_suggestions(code_hash):

return opus_analyze(code)

3. Используйте high только где критично

effort_by_task = {

"suggestions": "low", # Быстро

"refactoring": "medium", # Баланс

"security": "high" # Точность важнее скорости

}

5. ? Доступность из России

Проблема: Прямой доступ к Anthropic API заблокирован.

Варианты:

VPN + зарубежная карта (самый простой)

Proxy-сервисы (добавляют latency и стоимость)

Self-hosted альтернативы (теряете качество)

? Рекомендации по внедрению

Step 1: Начните с низкого риска

Не делайте так:

python

❌ Сразу в production для критичных систем

ai_deploy_to_prod(untested_code)

Делайте так:

python

✅ Начните с безопасных задач

tasks_by_risk = {

"low_risk": [

"Генерация unit-тестов",

"Документация",

"Code suggestions (без auto-commit)"

],

"medium_risk": [

"Рефакторинг некритичных модулей",

"SQL оптимизация (с review)"

],

"high_risk": [

"Security audit (обязательно с human review)",

"Архитектурные решения (консультативно)"

]

}

Step 2: Используйте effort стратегически

python

Маппинг задач на уровни effort

EFFORT_STRATEGY = {

# Low: быстро и дешево

"documentation": "low",

"code_formatting": "low",

"simple_queries": "low",

# Medium: баланс (90% задач)

"code_generation": "medium",

"refactoring": "medium",

"bug_analysis": "medium",

# High: точность критична

"security_review": "high",

"architecture_decisions": "high",

"production_incidents": "high"

}

def call_opus(task_type, prompt):

effort = EFFORT_STRATEGY.get(task_type, "medium")

return client.messages.create(

model="claude-opus-4-5-20251101",

effort=effort,

messages=[{"role": "user", "content": prompt}]

)

Step 3: Мониторинг и метрики

Что логировать:

python

import structlog

logger = structlog.get_logger()

def monitored_opus_call(task, prompt):

start_time = time.time()

response = client.messages.create(

model="claude-opus-4-5-20251101",

messages=[{"role": "user", "content": prompt}]

)

latency = time.time() - start_time

logger.info(

"opus_api_call",

task=task,

input_tokens=response.usage.input_tokens,

output_tokens=response.usage.output_tokens,

latency_ms=latency * 1000,

cost_usd=(

response.usage.input_tokens * 5 / 1_000_000 +

response.usage.output_tokens * 25 / 1_000_000

)

)

return response

Dashboard метрик:

? Токены (input/output) по задачам

⏱️ Latency (P50, P95, P99)

? Стоимость в разрезе по командам/проектам

✅ Acceptance rate (сколько suggestions принято)

Step 4: Интеграция в CI/CD

text

.github/workflows/ai-review.yml

name: AI Code Review

on: [pull_request]

jobs:

ai-review:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v3

- name: Run Opus 4.5 Review

run: |

python scripts/ai_review.py \

--pr-number ${{ github.event.pull_request.number }} \

--effort high

- name: Post Review Comments

uses: actions/github-script@v6

with:

script: |

// Постим комментарии от AI в PR

Step 5: Error handling и rate limiting

python

from anthropic import Anthropic, RateLimitError, APIError

import time

from tenacity import retry, stop_after_attempt, wait_exponential

@retry(

stop=stop_after_attempt(3),

wait=wait_exponential(multiplier=1, min=2, max=10)

)

def robust_opus_call(prompt, max_tokens=2048):

"""Надёжный вызов с retry логикой"""

client = Anthropic(api_key="your_api_key")

try:

response = client.messages.create(

model="claude-opus-4-5-20251101",

max_tokens=max_tokens,

messages=[{"role": "user", "content": prompt}]

)

return response

except RateLimitError as e:

logger.warning("Rate limit hit, retrying...", error=str(e))

raise # tenacity сделает retry

except APIError as e:

logger.error("API error", error=str(e))

# Fallback на другую модель?

return fallback_to_gpt4(prompt)

? Выводы: кому и зачем это нужно

✅ Используйте Opus 4.5 для:

Code generation, review, refactoring

Лучший SWE-bench результат (80.9%)

Экономия времени senior devs

AI-агенты для DevOps

Автономная работа 30+ минут

Валидация IaC, monitoring анализ

Technical writing и документация

effort=low дает экономию 70% токенов

Готовые к публикации тексты

SQL и data engineering

Оптимизация запросов

Генерация ETL пайплайнов

Security analysis

В 4.6 раза устойчивее к prompt injection

Audit terraform/k8s конфигов

⚠️ Используйте осторожно для:

Multimodal tasks → лучше GPT-4V

Long-horizon planning → лучше Gemini 3 Pro

Критичные системы → только с human oversight

Real-time applications → latency до 60 секунд на high effort

? Экономика в цифрах:

Снижение стоимости: 3x

Экономия токенов: 48-76%

ROI для команды из 10 разработчиков: $4800-6000/год

Окупаемость: меньше месяца

-

Кому принадлежит Gemini?

-

Как работает Gemini?

-

Является ли Gemini точным?

-

Может ли Gemini помочь с конкретными задачами или вопросами?

-

Является ли Gemini бесплатным сервисом?

-

Можно ли использовать Gemini на мобильных устройствах?

-

Доступен ли Gemini на разных языках?

-

Как начать работу с Gemini?

Войти в Gemini: быстрый и безопасный доступ к вашему ИИ-помощнику

- Исследуйте возможности Gemini, передового ИИ от Google, созданного для преобразования вашей работы и творчества.

Что такое Gemini

- Gemini — это революционная разработка в области искусственного интеллекта, созданная компанией Google. Этот многофункциональный ИИ-помощник

Регистрация Gemini в России: Полное Руководство

- Gemini — это многофункциональный искусственный интеллект, способный генерировать тексты, переводить языки, писать код, анализировать данные и многое